※本記事は2025年7月時点の情報に基づいて執筆されています。内容の正確性には万全を期していますが、最新情報は各公式サイトをご確認ください。

大容量データの保存・バックアップにおいて、オブジェクトストレージは現代のIT基盤に欠かせない技術となっています。特に国内事業者が提供するS3互換サービスは、データ主権やレイテンシーの観点から注目を集めています。

目次

オブジェクトストレージとは

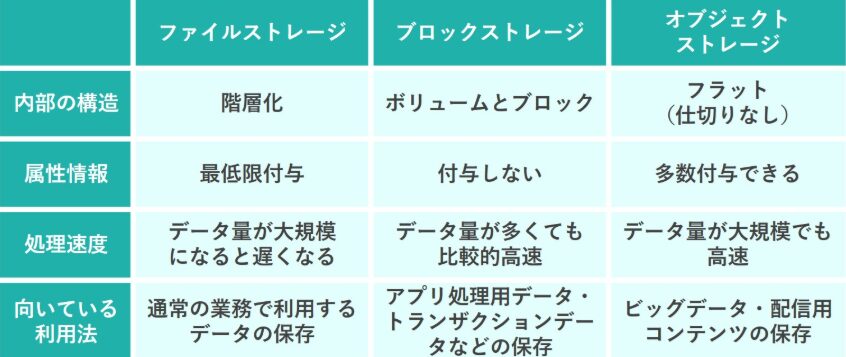

オブジェクトストレージは、データをオブジェクト単位で管理するストレージアーキテクチャです。従来のファイルシステムとは異なり、フラットな構造でデータを保存し、HTTP/HTTPSを通じてアクセスします。

主要な特徴

- 無制限のスケーラビリティ:ペタバイト級の容量対応

- HTTP/HTTPS アクセス:Web API経由での操作

- メタデータ管理:豊富な属性情報の付与

- 地理的分散:複数データセンターでの冗長化

国内オブジェクトストレージ比較表

| サービス名 | 容量単価(円/GB/月) | 転送料金(円/GB) | S3互換性 | 国内DC | 特徴 |

|---|---|---|---|---|---|

| Wasabi(Arena) | 8円 | 無料 | ○ | ○ | 最安値クラス |

| ConoHa Object Storage | 15円 | 15円 | ○ | ○ | 高速・安定 |

| KAGOYA S3 | 12円 | 10円 | ○ | ○ | 老舗の信頼性 |

| さくらのクラウド | 10円 | 10円 | ○ | ○ | 国産クラウド |

| ニフクラ | 20円 | 15円 | ○ | ○ | エンタープライズ |

| Z.com Cloud | 10円 | 5円 | ○ | ○ | GMO系列 |

S3互換性の重要性

1. ツール・ライブラリの豊富さ

S3互換性により、既存のAWS向けツールがそのまま利用可能です。

Copy# s3cmd による操作例

s3cmd put large_file.zip s3://mybucket/

s3cmd sync ./backup/ s3://mybucket/backup/

s3cmd ls s3://mybucket/ --recursive

2. プログラミング言語での利用

Copy# Python boto3 での利用例

import boto3

# S3互換ストレージへの接続

s3_client = boto3.client(

's3',

endpoint_url='https://s3.tyo1.conoha.io',

aws_access_key_id='YOUR_ACCESS_KEY',

aws_secret_access_key='YOUR_SECRET_KEY'

)

# ファイルアップロード

s3_client.upload_file('local_file.txt', 'bucket-name', 'remote_file.txt')

# ファイルダウンロード

s3_client.download_file('bucket-name', 'remote_file.txt', 'downloaded_file.txt')

3. WordPressとの連携

Copy// WP Offload Media での設定例

define('AS3CF_SETTINGS', serialize(array(

'provider' => 's3',

'access-key-id' => 'YOUR_ACCESS_KEY',

'secret-access-key' => 'YOUR_SECRET_KEY',

'bucket' => 'your-bucket-name',

'region' => 'ap-northeast-1',

'custom-domain' => 'your-cdn-domain.com',

'enable-object-prefix' => true,

'object-prefix' => 'wp-content/uploads/',

'force-https' => true,

)));

Wasabi代替サービス分析

1. コスト比較分析

Wasabi(Arena経由)

- 容量:8円/GB/月

- 転送:無料(90日ルール適用)

- 最小課金:1TB

国内代替候補

| サービス | 1TB/月 | 10TB/月 | 転送コスト含む |

|---|---|---|---|

| Wasabi(Arena) | 8,000円 | 80,000円 | 転送無料 |

| さくらのクラウド | 10,000円 | 100,000円 | +転送料 |

| ConoHa | 15,000円 | 150,000円 | +転送料 |

| Z.com Cloud | 10,000円 | 100,000円 | +転送料 |

2. 性能比較

Copy# 各サービスの性能テスト例

#!/bin/bash

# アップロード速度テスト

test_upload() {

local endpoint="$1"

local service_name="$2"

echo "Testing $service_name upload speed..."

time aws s3 cp test_1gb.bin s3://testbucket/ \

--endpoint-url="$endpoint" \

--cli-read-timeout=300 \

--cli-connect-timeout=60

}

# ダウンロード速度テスト

test_download() {

local endpoint="$1"

local service_name="$2"

echo "Testing $service_name download speed..."

time aws s3 cp s3://testbucket/test_1gb.bin ./downloaded_1gb.bin \

--endpoint-url="$endpoint"

}

# 各サービスのテスト実行

test_upload "https://s3.tyo1.conoha.io" "ConoHa"

test_upload "https://s3.isk01.sakurastorage.jp" "さくらのクラウド"

test_upload "https://s3.ap-northeast-1.wasabisys.com" "Wasabi"

3. 機能比較表

| 機能 | Wasabi | ConoHa | さくら | KAGOYA |

|---|---|---|---|---|

| バージョニング | ○ | ○ | ○ | ○ |

| ライフサイクル | ○ | ○ | ○ | ○ |

| 暗号化 | ○ | ○ | ○ | ○ |

| CDN連携 | × | ○ | ○ | ○ |

| 国内サポート | △ | ○ | ○ | ○ |

| 監査ログ | ○ | ○ | ○ | ○ |

バックアップ用途での最適化

1. 世代管理とライフサイクル

Copy{

"Rules": [

{

"ID": "BackupRetentionRule",

"Status": "Enabled",

"Filter": {

"Prefix": "backup/"

},

"Transitions": [

{

"Days": 30,

"StorageClass": "GLACIER"

},

{

"Days": 90,

"StorageClass": "DEEP_ARCHIVE"

}

],

"Expiration": {

"Days": 2555

}

}

]

}

2. 増分バックアップスクリプト

Copy#!/bin/bash

# incremental_backup.sh

BACKUP_SOURCE="/var/www/html"

BUCKET_NAME="backup-bucket"

BACKUP_PREFIX="web-backup"

SNAPSHOT_FILE="/tmp/backup_snapshot.txt"

LOG_FILE="/var/log/backup.log"

# 前回のスナップショット取得

if [ -f "$SNAPSHOT_FILE" ]; then

LAST_BACKUP=$(cat "$SNAPSHOT_FILE")

else

LAST_BACKUP="1970-01-01"

fi

# 現在の日時

CURRENT_TIME=$(date +"%Y-%m-%d_%H-%M-%S")

# 変更されたファイルのみを検出

find "$BACKUP_SOURCE" -newer "$SNAPSHOT_FILE" -type f > /tmp/changed_files.txt

# 変更されたファイルをS3にアップロード

while IFS= read -r file; do

relative_path=${file#$BACKUP_SOURCE/}

s3_path="s3://$BUCKET_NAME/$BACKUP_PREFIX/$CURRENT_TIME/$relative_path"

aws s3 cp "$file" "$s3_path" --endpoint-url="YOUR_ENDPOINT" 2>> "$LOG_FILE"

if [ $? -eq 0 ]; then

echo "$(date): Uploaded $file" >> "$LOG_FILE"

else

echo "$(date): Failed to upload $file" >> "$LOG_FILE"

fi

done < /tmp/changed_files.txt

# スナップショットファイル更新

touch "$SNAPSHOT_FILE"

# 古いバックアップの削除(30日以上前)

aws s3 ls "s3://$BUCKET_NAME/$BACKUP_PREFIX/" --endpoint-url="YOUR_ENDPOINT" | \

while read -r line; do

backup_date=$(echo "$line" | awk '{print $2}')

if [[ "$backup_date" < "$(date -d '30 days ago' +%Y-%m-%d)" ]]; then

folder_name=$(echo "$line" | awk '{print $4}')

aws s3 rm "s3://$BUCKET_NAME/$BACKUP_PREFIX/$folder_name" --recursive --endpoint-url="YOUR_ENDPOINT"

fi

done

3. 監視・アラート設定

Copy#!/bin/bash

# backup_monitoring.sh

BUCKET_NAME="backup-bucket"

ENDPOINT_URL="YOUR_ENDPOINT"

SLACK_WEBHOOK="YOUR_SLACK_WEBHOOK"

EXPECTED_SIZE_GB=100 # 期待するバックアップサイズ

# バックアップサイズ確認

backup_size=$(aws s3api list-objects-v2 \

--bucket "$BUCKET_NAME" \

--endpoint-url="$ENDPOINT_URL" \

--query 'sum(Contents[].Size)' \

--output text)

backup_size_gb=$((backup_size / 1024 / 1024 / 1024))

# サイズ異常の検出

if [ "$backup_size_gb" -lt "$EXPECTED_SIZE_GB" ]; then

message="⚠️ バックアップサイズ異常: ${backup_size_gb}GB (期待値: ${EXPECTED_SIZE_GB}GB)"

curl -X POST -H 'Content-type: application/json' \

--data "{\"text\":\"$message\"}" \

"$SLACK_WEBHOOK"

fi

# 最新バックアップの確認

latest_backup=$(aws s3 ls "s3://$BUCKET_NAME/" --endpoint-url="$ENDPOINT_URL" | \

sort | tail -1 | awk '{print $1, $2}')

latest_backup_timestamp=$(date -d "$latest_backup" +%s)

current_timestamp=$(date +%s)

time_diff=$((current_timestamp - latest_backup_timestamp))

# 24時間以上バックアップがない場合の警告

if [ "$time_diff" -gt 86400 ]; then

message="🚨 バックアップが24時間以上更新されていません"

curl -X POST -H 'Content-type: application/json' \

--data "{\"text\":\"$message\"}" \

"$SLACK_WEBHOOK"

fi

高可用性・災害対策

1. マルチリージョン構成

Copy#!/bin/bash

# multi_region_sync.sh

PRIMARY_ENDPOINT="https://s3.tyo1.conoha.io"

SECONDARY_ENDPOINT="https://s3.isk01.sakurastorage.jp"

BUCKET_NAME="disaster-backup"

# プライマリからセカンダリへの同期

aws s3 sync s3://$BUCKET_NAME/ s3://$BUCKET_NAME/ \

--source-region ap-northeast-1 \

--region ap-northeast-1 \

--endpoint-url="$PRIMARY_ENDPOINT" \

--cli-read-timeout=300 \

--cli-connect-timeout=60 \

| aws s3 sync - s3://$BUCKET_NAME/ \

--endpoint-url="$SECONDARY_ENDPOINT"

2. 整合性チェック

Copy#!/usr/bin/env python3

# integrity_check.py

import boto3

import hashlib

import sys

from concurrent.futures import ThreadPoolExecutor, as_completed

def calculate_s3_etag(file_path, chunk_size=8 * 1024 * 1024):

"""S3 ETagの計算(マルチパートアップロード対応)"""

with open(file_path, 'rb') as f:

chunks = []

while True:

chunk = f.read(chunk_size)

if not chunk:

break

chunks.append(hashlib.md5(chunk).digest())

if len(chunks) == 1:

return hashlib.md5(chunks[0]).hexdigest()

else:

combined = b''.join(chunks)

return f"{hashlib.md5(combined).hexdigest()}-{len(chunks)}"

def verify_object_integrity(s3_client, bucket, key, local_path):

"""オブジェクトの整合性確認"""

try:

response = s3_client.head_object(Bucket=bucket, Key=key)

s3_etag = response['ETag'].strip('"')

local_etag = calculate_s3_etag(local_path)

return key, s3_etag == local_etag

except Exception as e:

return key, False

def main():

# S3クライアント設定

s3_client = boto3.client(

's3',

endpoint_url='YOUR_ENDPOINT',

aws_access_key_id='YOUR_ACCESS_KEY',

aws_secret_access_key='YOUR_SECRET_KEY'

)

bucket_name = 'your-bucket'

local_base_path = '/path/to/local/files'

# 並列処理で整合性チェック

with ThreadPoolExecutor(max_workers=5) as executor:

futures = []

# バケット内のオブジェクト一覧取得

paginator = s3_client.get_paginator('list_objects_v2')

for page in paginator.paginate(Bucket=bucket_name):

for obj in page.get('Contents', []):

key = obj['Key']

local_path = f"{local_base_path}/{key}"

future = executor.submit(

verify_object_integrity,

s3_client, bucket_name, key, local_path

)

futures.append(future)

# 結果の確認

failed_objects = []

for future in as_completed(futures):

key, is_valid = future.result()

if not is_valid:

failed_objects.append(key)

print(f"❌ 整合性エラー: {key}")

else:

print(f"✅ OK: {key}")

if failed_objects:

print(f"\n🚨 {len(failed_objects)}個のオブジェクトで整合性エラーが検出されました")

sys.exit(1)

else:

print("\n✅ すべてのオブジェクトの整合性が確認されました")

if __name__ == "__main__":

main()

コスト最適化の実践

1. 重複排除

Copy#!/bin/bash

# deduplication.sh

BUCKET_NAME="storage-bucket"

ENDPOINT_URL="YOUR_ENDPOINT"

TEMP_DIR="/tmp/dedup"

mkdir -p "$TEMP_DIR"

# S3オブジェクトのハッシュ値計算

aws s3api list-objects-v2 --bucket "$BUCKET_NAME" --endpoint-url="$ENDPOINT_URL" \

--query 'Contents[].{Key:Key,ETag:ETag,Size:Size}' --output json > "$TEMP_DIR/objects.json"

# 重複ファイルの検出

python3 << 'EOF'

import json

import requests

from collections import defaultdict

with open('/tmp/dedup/objects.json', 'r') as f:

objects = json.load(f)

# ETags(ハッシュ値)でグループ化

etag_groups = defaultdict(list)

for obj in objects:

etag = obj['ETag'].strip('"')

etag_groups[etag].append(obj)

# 重複ファイルの検出

duplicates = {etag: objs for etag, objs in etag_groups.items() if len(objs) > 1}

if duplicates:

print(f"発見された重複ファイル: {sum(len(objs) - 1 for objs in duplicates.values())}個")

# 重複ファイルリストの出力

with open('/tmp/dedup/duplicates.txt', 'w') as f:

for etag, objs in duplicates.items():

f.write(f"ETag: {etag}\n")

for obj in objs[1:]: # 最初の1つを除いて削除対象

f.write(f" DELETE: {obj['Key']}\n")

f.write("\n")

else:

print("重複ファイルは検出されませんでした")

EOF

# 重複ファイルの削除(慎重に実行)

if [ -f "$TEMP_DIR/duplicates.txt" ]; then

echo "重複ファイルの削除を実行しますか? (y/N)"

read -r response

if [[ "$response" =~ ^[Yy]$ ]]; then

grep "DELETE:" "$TEMP_DIR/duplicates.txt" | while read -r line; do

key=$(echo "$line" | cut -d':' -f2- | xargs)

aws s3 rm "s3://$BUCKET_NAME/$key" --endpoint-url="$ENDPOINT_URL"

done

fi

fi

2. 自動アーカイブ

Copy#!/bin/bash

# auto_archive.sh

BUCKET_NAME="archive-bucket"

ENDPOINT_URL="YOUR_ENDPOINT"

ARCHIVE_DAYS=30

DEEP_ARCHIVE_DAYS=365

# 30日以上アクセスされていないファイルをアーカイブ

aws s3api list-objects-v2 \

--bucket "$BUCKET_NAME" \

--endpoint-url="$ENDPOINT_URL" \

--query "Contents[?LastModified<'$(date -d "$ARCHIVE_DAYS days ago" --iso-8601)'].Key" \

--output text | \

while read -r key; do

if [ -n "$key" ]; then

aws s3api copy-object \

--bucket "$BUCKET_NAME" \

--copy-source "$BUCKET_NAME/$key" \

--key "$key" \

--storage-class GLACIER \

--endpoint-url="$ENDPOINT_URL"

echo "Archived: $key"

fi

done

よくある質問(FAQ)

Q. S3互換性がないサービスでも使えますか? A. s3proxyなどのプロキシツールを使用することで、S3互換性を追加できます。

Q. データ転送料金を抑える方法はありますか? A. CDNとの組み合わせ、リージョン選択、転送量無料のサービス選択が効果的です。

Q. バックアップの信頼性はどう確保すればよいですか? A. 複数サービスでの冗長化、定期的な整合性チェック、リストア テストが重要です。

おすすめサーバー・ストレージサービス

大容量データの管理には、適切なサーバー環境とストレージサービスの組み合わせが重要です:

高性能サーバー環境

- ConoHa VPS:オブジェクトストレージとの親和性が高い

- KAGOYA CLOUD VPS:安定したネットワーク環境

専用サーバー

- KAGOYA マネージド専用サーバー:大量データ処理に最適

これらのサービスは、オブジェクトストレージとの高速連携、安定したデータ転送、柔軟なスケーリングを提供し、効率的なデータ管理基盤を構築できます。