※本記事は2026年1月5日時点の情報をもとに更新しています。料金・仕様は改定されることがあるため、最終的には各公式サイトの最新情報をご確認ください。

大容量データの保存・バックアップにおいて、オブジェクトストレージは現代のIT基盤に欠かせない技術となっています。特に国内事業者(または国内DCを選べる事業者)が提供するS3互換サービスは、データ主権やレイテンシーの観点から注目を集めています。

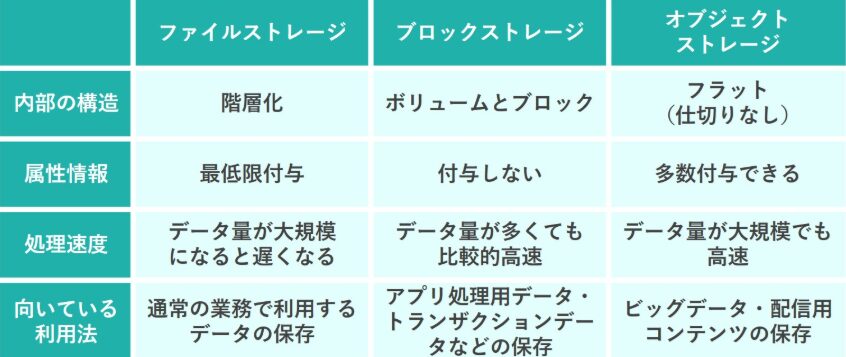

オブジェクトストレージとは

オブジェクトストレージは、データを「オブジェクト」単位で管理するストレージアーキテクチャです。従来のファイルシステム(階層型)とは異なり、フラットな構造でデータを保存し、HTTP/HTTPS経由のAPIでアクセスします。

各オブジェクトにはメタデータを付与でき、拡張性(大量データ・多数ファイル)と、耐久性・冗長化を重視した設計が一般的です。バックアップ、ログ保管、画像・動画配信、アーカイブ、AI/分析用データレイクなど幅広い用途で使われます。

主要な特徴

- 無制限のスケーラビリティ:ペタバイト級の容量対応

- HTTP/HTTPS アクセス:Web API経由での操作

- メタデータ管理:豊富な属性情報の付与

- 地理的分散:複数データセンターでの冗長化

国内オブジェクトストレージ比較表

国内で選びやすい主要候補を「料金の分かりやすさ」「転送・リクエスト課金の有無」「最低利用・最低課金期間」中心に整理しました。S3互換の“範囲”はサービスごとに差があるため、後述のチェック項目も合わせて確認してください。

| サービス | 容量単価の目安 | 転送料金 | リクエスト課金 | 最低利用・課金ルール | 国内DC | ひとこと |

|---|---|---|---|---|---|---|

| WebARENA Wasabi(NTTPC) | 0.034210円/GB/日(概算で約1.03円/GB/月) | なし | なし | 最低利用料1TB・最低課金期間30日(オブジェクト削除時) | ○ | 「転送・API課金なし」でコスパ重視。最低利用1TBが前提。 |

| ConoHa Object Storage | 545円/100GB/月(=約5.45円/GB/月) | なし | なし | 100GB単位の月額課金 | ○ | シンプルな月額定額。S3互換で扱いやすい。 |

| さくらのクラウド オブジェクトストレージ | 495円/バケット/月(100GiB込み)+超過49.5円/10GiB | 10GiB/月まで込み(超過49.5円/10GiB) | 100,000回/月まで込み(超過1円/1,000回) | バケット単位の月額(オブジェクト数100,000個まで込み) | ○ | 「込み」の範囲が明確。小〜中規模で見積りしやすい。 |

| ニフクラ オブジェクトストレージサービス | 0.00358円/GB・時間(=約2.58円/GB/月) | グローバル側通信はリージョンごと10TB/月まで無料、超過20円/GB | (操作自体はストレージ料金に含まれないが、状況により転送量に計上) | GB・時間の従量課金 | ○ | 大量保管ほど単価が効く。通信量(10TB無料枠)も要計算。 |

| Z.com Cloud(for App) | 11円/GB/月(別途サービス維持調整費) | (オブジェクトストレージの転送量は無料) | 0.5円/1,000リクエスト(別途サービス維持調整費) | 月額従量 | ○ | アプリ基盤と合わせて使う前提の価格感。リクエスト課金あり。 |

S3互換性の重要性

「S3互換」は、Amazon S3向けに作られたツール・ライブラリ・アプリ連携(バックアップ、同期、WordPress、CI/CDなど)を流用できるのが最大のメリットです。一方で、互換といっても全APIが同一とは限らないため、実運用前に“自分の用途で必要な範囲”が動くか検証しましょう。

主要な特徴

- aws-cli / s3cmd / rclone / restic など、既存ツールの流用がしやすい

- boto3(Python)など、言語SDKからの接続が容易

- WordPressのメディア保存・配信をS3互換に逃がせる(プラグインによる)

ツール・ライブラリの豊富さ

たとえば CLI では aws-cli / s3cmd / rclone などが定番です。S3互換なら、エンドポイントを変えるだけで同じ操作感で使えるケースが多く、移行もしやすくなります。

# s3cmd による操作例

s3cmd put large_file.zip s3://mybucket/

s3cmd sync ./backup/ s3://mybucket/backup/

s3cmd ls s3://mybucket/ --recursive

プログラミング言語での利用

アプリ側からオブジェクトストレージを直接使う場合、boto3(Python)などのSDKでS3互換接続ができると実装が楽になります。下記は ConoHa のエンドポイント例ですが、他社でも同様に endpoint_url を差し替えて対応します。

# Python boto3 での利用例

import boto3

# S3互換ストレージへの接続

s3_client = boto3.client(

's3',

endpoint_url='https://s3.tyo1.conoha.io',

aws_access_key_id='YOUR_ACCESS_KEY',

aws_secret_access_key='YOUR_SECRET_KEY'

)

# ファイルアップロード

s3_client.upload_file('local_file.txt', 'bucket-name', 'remote_file.txt')

# ファイルダウンロード

s3_client.download_file('bucket-name', 'remote_file.txt', 'downloaded_file.txt')

WordPressとの連携

WordPressの画像・動画などメディアファイルをS3互換ストレージへ置くことで、Webサーバーのディスク枯渇対策、バックアップの単純化、配信負荷の分散が狙えます。プラグイン(例:WP Offload Media系)では、S3互換をサポートしている場合があります。

// WP Offload Media での設定例

define('AS3CF_SETTINGS', serialize(array(

'provider' => 's3',

'access-key-id' => 'YOUR_ACCESS_KEY',

'secret-access-key' => 'YOUR_SECRET_KEY',

'bucket' => 'your-bucket-name',

'region' => 'tyo1',

'domain' => 'https://s3.tyo1.conoha.io'

)));

関連動画(日本語)

操作イメージを掴むために、日本語で見られる公式・解説動画も貼っておきます(必要な部分だけつまみ見でOK)。

Wasabi代替サービス分析

コスト比較分析

下記は「ストレージ料金のみ」を概算したざっくり比較です。実際には、転送量・リクエスト・無料枠超過・最小課金期間(削除)などで変わるため、必ず自分の運用前提で見積もりしてください。

| サービス | 1TB/月(概算) | 10TB/月(概算) | 注意点 |

|---|---|---|---|

| WebARENA Wasabi(NTTPC) | 1,051円 | 10,507円 | 1TB最低利用・日額合算。月の日数で変動。削除は30日最低課金。 |

| ConoHa Object Storage | 5,450円 | 54,500円 | 100GB単位。厳密な「1TB=1024GB」だと端数分の追加が必要になる場合あり。 |

| さくらのクラウド オブジェクトストレージ | 5,069円 | 50,688円 | バケット月額+超過。転送・リクエスト・オブジェクト数の「込み」を超えると追加。 |

| ニフクラ オブジェクトストレージサービス | 2,640円 | 26,400円 | GB・時間の従量。グローバル側通信は10TB/月まで無料、超過分は課金。 |

| Z.com Cloud(for App) | 12,390円 | 123,904円 | 別途サービス維持調整費が加算されるため、実請求はこの概算より増える。 |

性能比較

性能(アップロード/ダウンロード速度、レイテンシー)は、回線・リージョン・オブジェクトサイズ・同時接続数で大きく変わります。実運用に近い条件でテストするのが最も確実です。

# 各サービスの性能テスト例

#!/bin/bash

set -euo pipefail

# 事前準備:

# 1) aws cli をインストール

# 2) 各サービスのアクセスキー/シークレットを設定(環境変数でもOK)

# 3) テスト用バケット(testbucket)を作成

# 4) テストファイル作成: dd if=/dev/zero of=test_1gb.bin bs=1M count=1024

# アップロード速度テスト

test_upload() {

local endpoint="$1"

local service_name="$2"

echo "Testing ${service_name} upload speed..."

time aws s3 cp ./test_1gb.bin s3://testbucket/ --endpoint-url="${endpoint}" --cli-read-timeout 300 --cli-connect-timeout 60

}

# ダウンロード速度テスト

test_download() {

local endpoint="$1"

local service_name="$2"

echo "Testing ${service_name} download speed..."

time aws s3 cp s3://testbucket/test_1gb.bin ./downloaded_1gb.bin --endpoint-url="${endpoint}" --cli-read-timeout 300 --cli-connect-timeout 60

}

# 各サービスのテスト実行(エンドポイントはサービスの案内に合わせて変更)

test_upload "https://s3.tyo1.conoha.io" "ConoHa"

test_upload "https://s3.isk01.sakurastorage.jp" "さくらのクラウド"

test_upload "https://s3.ap-northeast-1.wasabisys.com" "Wasabi"

test_download "https://s3.tyo1.conoha.io" "ConoHa"

test_download "https://s3.isk01.sakurastorage.jp" "さくらのクラウド"

test_download "https://s3.ap-northeast-1.wasabisys.com" "Wasabi"

機能比較表

“S3互換”は便利ですが、互換の範囲が異なると「使いたい機能が足りない」「ツールが想定通りに動かない」ことがあります。特にバックアップ用途・メディア配信用途では、下記の観点を先にチェックするのが安全です。

| チェック項目 | 見るべき理由 | 事前に確認したいポイント例 |

|---|---|---|

| S3互換の範囲 | 「S3互換」と言ってもAPI/署名方式/パス形式などの差が出やすい | 署名v2/v4、Virtual-hosted / Path-style、マルチパートアップロード、署名付きURL |

| 課金の単位 | 月額・日額・GB時間、最低利用料などで見積りが大きく変わる | 最低利用(例:1TB)、最低課金期間(削除時の残日数課金)、1GB未満切り上げ等 |

| 転送量の扱い | バックアップ用途は「取り出し・配信」が増えると想定外に跳ねる | 転送無料の範囲、無料枠(例:10TB/月)と超過単価、同リージョン内通信の扱い |

| リクエスト課金 | 小さいオブジェクトが多い/頻繁にLISTする運用では効いてくる | GET/PUT/LISTの単価、無料枠、S3互換ツールの挙動でLISTが増えないか |

| 耐久性・冗長化 | 「バックアップ先」なら耐久性と障害時の復旧導線が最重要 | SLA/SLO、冗長化方式、障害情報の公開、復旧手順、サポート窓口 |

| 運用機能 | 暗号化・バージョニング・ライフサイクル等が使えると運用が楽 | サーバーサイド暗号化、バージョニング、ライフサイクル、オブジェクトロック(WORM) |

バックアップ用途での最適化

バックアップ用途では、単純な「保存単価」だけでなく、増分バックアップの頻度、復元の頻度、削除のルール(最低課金期間)、転送無料枠が効いてきます。特にWasabi系は「削除時の最低保存期間」ルールがあるため、世代管理と相性を意識して設計しましょう。

世代管理とライフサイクル

世代管理(バージョニング)やライフサイクル(古い世代を自動削除・アーカイブ)は、バックアップ運用の手間を減らし、コストの暴発を防ぐのに有効です。対応可否や仕様はサービスごとに異なるため、必要なら必ず検証してください。

{

"Rules": [

{

"ID": "BackupRetentionRule",

"Status": "Enabled",

"Filter": {

"Prefix": "backup/"

},

"Transitions": [

{

"Days": 30,

"StorageClass": "GLACIER"

}

],

"Expiration": {

"Days": 365

}

}

]

}

増分バックアップスクリプト

増分バックアップ(差分のみ同期)を徹底すると、転送量とリクエスト数を抑えやすく、復元ポイントも整理しやすくなります。rclone / restic / borg など、用途に合うものを選びましょう。

#!/bin/bash

# シンプルな日次バックアップ例(差分同期)

# 注意:実運用では暗号化・除外設定・エラーハンドリングを追加してください

SOURCE_DIR="/var/www"

BACKUP_DIR="/backup/work"

DATE=$(date +%Y%m%d)

mkdir -p "${BACKUP_DIR}/${DATE}"

rsync -a --delete "${SOURCE_DIR}/" "${BACKUP_DIR}/${DATE}/"

# S3互換へアップロード(aws cli)

aws s3 sync "${BACKUP_DIR}/${DATE}/" "s3://your-bucket/backup/${DATE}/" --endpoint-url="https://s3.tyo1.conoha.io"

監視・アラート設定

バックアップは「失敗しても気づかない」が最悪です。ジョブの成否、容量の増え方、転送量(無料枠超過の兆候)などを監視し、通知する仕組みを用意しましょう。

高可用性・災害対策

バックアップは「別リージョン」または「別事業者」へ二重化すると強くなります。国内で完結させたい場合でも、同一DC障害を想定して多重化を検討してください。

マルチリージョン構成

サービスによりリージョンが複数選べる場合があります。可用性重視なら、レプリケーション(または二重書き)で「別リージョンに常時コピー」を持つ設計が現実的です。

整合性チェック

定期的に整合性チェック(ハッシュ比較、サンプル復元テスト)を行うことで、バックアップの信頼性を高められます。バックアップは「取れている」より「戻せる」が重要です。

コスト最適化の実践

最後に、コストを下げるための実践テクニックです。オブジェクトストレージは「容量が増えると当たり前に請求も増える」ため、設計段階で“増え方”を制御しておくのがコツです。

重複排除

Copy#!/bin/bash

# deduplication.sh

BUCKET_NAME="storage-bucket"

ENDPOINT_URL="YOUR_ENDPOINT"

TEMP_DIR="/tmp/dedup"

mkdir -p "$TEMP_DIR"

# S3オブジェクトのハッシュ値計算

aws s3api list-objects-v2 --bucket "$BUCKET_NAME" --endpoint-url="$ENDPOINT_URL" \

--query 'Contents[].{Key:Key,ETag:ETag,Size:Size}' --output json > "$TEMP_DIR/objects.json"

# 重複ファイルの検出

python3 << 'EOF'

import json

import requests

from collections import defaultdict

with open('/tmp/dedup/objects.json', 'r') as f:

objects = json.load(f)

# ETags(ハッシュ値)でグループ化

etag_groups = defaultdict(list)

for obj in objects:

etag = obj['ETag'].strip('"')

etag_groups[etag].append(obj)

# 重複ファイルの検出

duplicates = {etag: objs for etag, objs in etag_groups.items() if len(objs) > 1}

if duplicates:

print(f"発見された重複ファイル: {sum(len(objs) - 1 for objs in duplicates.values())}個")

# 重複ファイルリストの出力

with open('/tmp/dedup/duplicates.txt', 'w') as f:

for etag, objs in duplicates.items():

f.write(f"ETag: {etag}\n")

for obj in objs[1:]: # 最初の1つを除いて削除対象

f.write(f" DELETE: {obj['Key']}\n")

f.write("\n")

else:

print("重複ファイルは検出されませんでした")

EOF

# 重複ファイルの削除(慎重に実行)

if [ -f "$TEMP_DIR/duplicates.txt" ]; then

echo "重複ファイルの削除を実行しますか? (y/N)"

read -r response

if [[ "$response" =~ ^[Yy]$ ]]; then

grep "DELETE:" "$TEMP_DIR/duplicates.txt" | while read -r line; do

key=$(echo "$line" | cut -d':' -f2- | xargs)

aws s3 rm "s3://$BUCKET_NAME/$key" --endpoint-url="$ENDPOINT_URL"

done

fi

fi

自動アーカイブ

Copy#!/bin/bash # auto_archive.sh BUCKET_NAME=”archive-bucket” ENDPOINT_URL=”YOUR_ENDPOINT” ARCHIVE_DAYS=30 DEEP_ARCHIVE_DAYS=365 # 30日以上アクセスされていないファイルをアーカイブ aws s3api list-objects-v2 \ –bucket “$BUCKET_NAME” \ –endpoint-url=”$ENDPOINT_URL” \ –query “Contents[?LastModified<‘$(date -d “$ARCHIVE_DAYS days ago” –iso-8601)’].Key” \ –output text | \ while read -r key; do if [ -n “$key” ]; then aws s3api copy-object \ –bucket “$BUCKET_NAME” \ –copy-source “$BUCKET_NAME/$key” \ –key “$key” \ –storage-class GLACIER \ –endpoint-url=”$ENDPOINT_URL” echo “Archived: $key” fi done

よくある質問(FAQ)

Q. 国内S3互換を選ぶ一番の理由は?

A. データ主権(国内保管)、レイテンシー、国内請求(円建て・国内サポート)などが主な理由です。

Q. 「転送無料」なら何でも安い?

A. 保存単価、最低利用料、削除時の最低課金期間、リクエスト課金の有無で総額は変わります。バックアップは復元時に転送が増えるため、無料枠や条件も必ず確認してください。

Q. Wasabi系の注意点は?

A. 直契約は最低月額(1TB相当)や、削除時の最低保存期間(既定90日)があります。WebARENA Wasabiは最低利用1TB・最低課金期間30日など、契約形態で条件が変わる点に注意です。

おすすめサーバー・ストレージサービス

オブジェクトストレージを活用する場合、バックアップ元となるサーバー側の安定性や回線も重要です。用途に応じて、下記のようなサーバー環境も検討してみてください(広告リンクを含みます)。